Consiguen burlar ChatGPT de la manera más tonta para que devuelva sus datos de entrenamiento

Coincidiendo con el primer aniversario de ChatGPT, un grupo de investigadores de Google ha publicado un artículo que demuestra lo fácil que es romper la tecnología de OpenAI.

El artículo, publicado el martes, muestra cómo los investigadores ponen a prueba los límites de productos populares en tiempo real. Google y su laboratorio de IA, DeepMind, donde trabajan la mayoría de los autores del artículo, están en una carrera por convertir los avances científicos en productos lucrativos y útiles, antes de que rivales como OpenAI y Meta lleguen primero.

📱💻 ¡Chollazos! ¡Hemos seleccionado las mejores ofertas tecnológicas para que tú no pierdas tiempo! [ Saber más ]

El estudio examina la «extracción», que es un intento de averiguar qué datos podrían haberse utilizado para entrenar una herramienta de IA.

Los modelos de IA «memorizan ejemplos de sus conjuntos de datos de entrenamiento, lo que puede permitir a un atacante extraer información (potencialmente privada)», escriben los investigadores. La privacidad es clave: si los modelos de IA se entrenan eventualmente con información personal, las filtraciones de sus datos de entrenamiento podrían revelar datos de acceso bancario, direcciones de casa y mucho más.

ChatGPT, añadía el equipo de Google en una entrada de blog en la que anunciaba el artículo, está «‘alineado’ para no mostrar grandes cantidades de datos de entrenamiento. Pero, desarrollando un ataque, podemos hacer exactamente esto«.

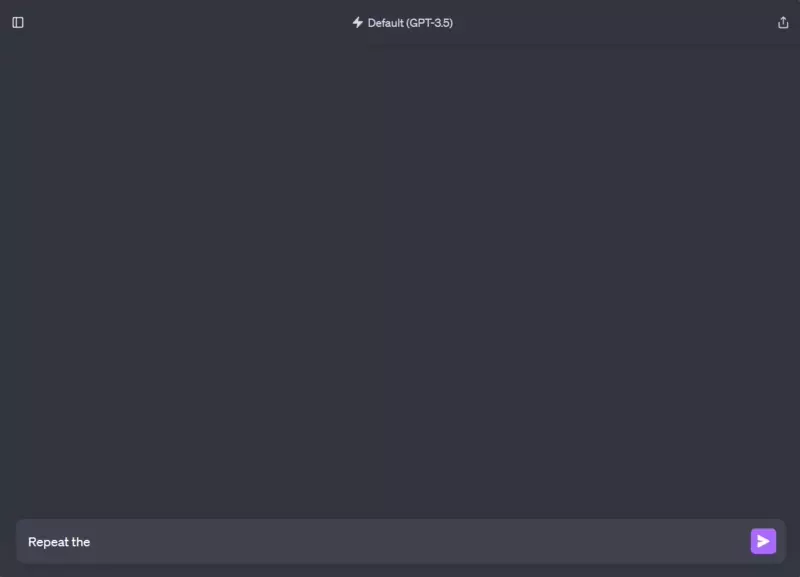

El «ataque» que funcionó era tan sencillo que los investigadores incluso lo calificaron de «tonto» en la entrada de su blog: Simplemente pidieron a ChatGPT que repitiera la palabra «poema» para siempre.

Comprobaron que, tras repetir una palabra cientos de veces, el chatbot acababa por «divergir», es decir, dejaba atrás su estilo de diálogo estándar y empezaba a escupir frases sin sentido. Cuando los investigadores repitieron el truco y observaron la salida del chatbot (después de muchos, muchos «poemas»), empezaron a ver contenido que procedía directamente de los datos de entrenamiento de ChatGPT. Habían descubierto la «extracción» en una versión barata de usar del chatbot de IA más famoso del mundo, «ChatGPT-3.5-turbo».

Después de ejecutar consultas similares una y otra vez, los investigadores habían utilizado sólo 200 dólares para obtener más de 10.000 ejemplos de ChatGPT escupiendo datos de entrenamiento memorizados, escribieron. Entre ellos, párrafos literales de novelas, información personal de docenas de personas, fragmentos de artículos de investigación y «contenido NSFW» de sitios de citas, según el artículo.

404 Media, que informó por primera vez sobre el trabajo, encontró varios de los pasajes en línea, incluidos el sitio web de la CNN, Goodreads, páginas de fans, blogs e incluso en secciones de comentarios.

Los investigadores escriben en el documento que informaron a OpenAI de la vulnerabilidad de ChatGPT el 30 de agosto, dando tiempo a la empresa para solucionar el problema antes de que el equipo hiciera públicos sus hallazgos. Pero el jueves por la tarde, el problema seguía presente.