NVIDIA presenta su arquitectura Blackwell: Rendimiento brutal en IA con menor consumo energético

En la conferencia GTC AI 2024, NVIDIA ha revelado su próxima arquitectura de GPU Blackwell. Durante el discurso de apertura de Jensen Huang, CEO de Nvidia, se presentaron las características clave de esta nueva generación de GPU.

Construida sobre un proceso de fabricación de 4NP TSMC y utilizando un diseño MCM para GPU unificada, la nueva arquitectura promete un rendimiento de IA mucho más alto y muchas otras mejoras arquitectónicas.

📱💻 ¡Chollazos! ¡Hemos seleccionado las mejores ofertas tecnológicas para que tú no pierdas tiempo! [ Saber más ]

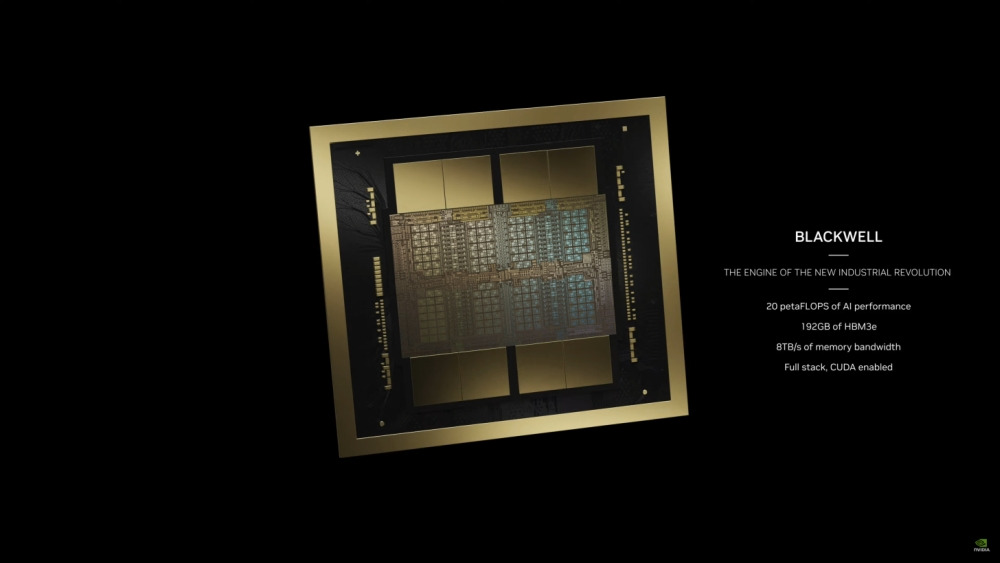

Anunciado como «el chip más potente del mundo» y el chip más grande físicamente posible, el Blackwell es un diseño MCM con dos GPU conectadas a través de una interfaz de alta velocidad de Nvidia de 10TB/s, creando una única GPU unificada.

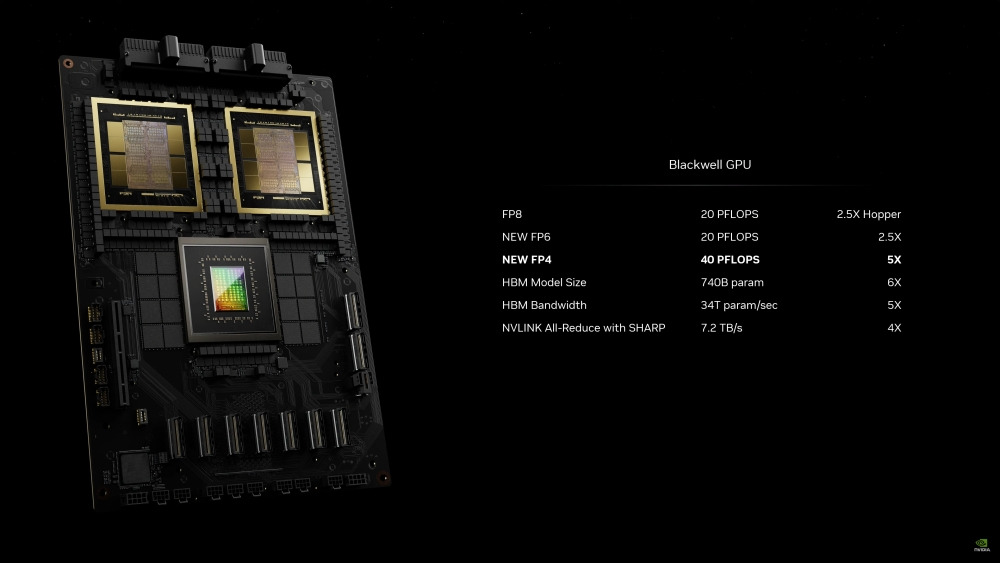

Está construido sobre un proceso personalizado de 4NP TSMC y cuenta con un total de 208.000 millones de transistores, con 192 GB de memoria HMB3e y 8 TB/s de ancho de banda de memoria, así como una coherencia total de caché de GPU. NVIDIA afirma que tiene un rendimiento de IA de 20 petaFLOPS, lo que representa cinco veces más rendimiento de IA en comparación con el Hopper H100.

Comparando la nueva arquitectura Blackwell completamente con la de Hopper, Nvidia afirma que ofrece 128.000 millones de transistores más, 5 veces el rendimiento de IA y 4 veces la memoria en el dado.

En términos de otras especificaciones, la GPU Nvidia Blackwell B200 cuenta con 160 SMs o 20,480 núcleos, 8 paquetes de HBM para 192 GB de memoria HBM3e, tiene soporte para PCIe 6.0 y tiene un TDP pico de 700W.

Nvidia lanzará la nueva arquitectura Blackwell como la plataforma Nvidia Blackwell GB200 Grace Blackwell Superchip, con dos GPU Tensor Core B200 y CPU Grace, conectados a través de un interconector de chip a chip NVLink de ultra baja potencia de 900GB/s.

Estará disponible en varios sistemas y placas de servidor, conectando hasta 72 GPU Blackwell y 36 CPUs Grace en el sistema de escala de rack NVIDIA GB200 NVL72, o como la placa de servidor HGX B200 con ocho GPU B200 para plataformas de IA generativa basadas en x86.

Todos los socios habituales están en la lista, incluyendo Cisco, Dell, Hewlett Packard Enterprise, Lenovo, Supermicro, Aivres, ASRock Rack, ASUS, Eviden, Foxconn, GIGABYTE, Inventec, Pegatron, QCT, Wistron, Wiwynn y ZT Systems.