Apple anuncia medidas para limitar la difusión de material de abuso sexual infantil

Como adelantábamos hace unas horas, Apple ha anunciado hoy nuevas medidas para limitar la difusión de material de abuso sexual infantil (o CSAM por sus siglas en inglés).

La compañía está introduciendo funciones de seguridad infantil en tres áreas, desarrolladas en colaboración con expertos en seguridad infantil.

En primer lugar, la aplicación Mensajes utilizará el aprendizaje automático en el dispositivo para advertir sobre contenido sensible al niño y a los padres, manteniendo las comunicaciones privadas ilegibles para Apple.

Por otro lado, iOS y iPadOS utilizarán nuevas aplicaciones de criptografía para ayudar a limitar la propagación de CSAM en línea, al tiempo que se diseña para la privacidad del usuario. La detección de este material en la app Fotos de iCloud del dispositivo proporcionará información valiosa a las fuerzas de seguridad sobre colecciones de CSAM.

Por último, Siri y Búsquedas proporcionarán a los padres y a los niños información ampliada y ayuda si se encuentran con situaciones inseguras. Siri y Búsquedas también intervendrán cuando los usuarios intenten buscar temas relacionados con el CSAM.

Estas funciones llegarán a finales de este año en las actualizaciones de iOS 15, iPadOS 15, watchOS 8 y macOS Monterey.

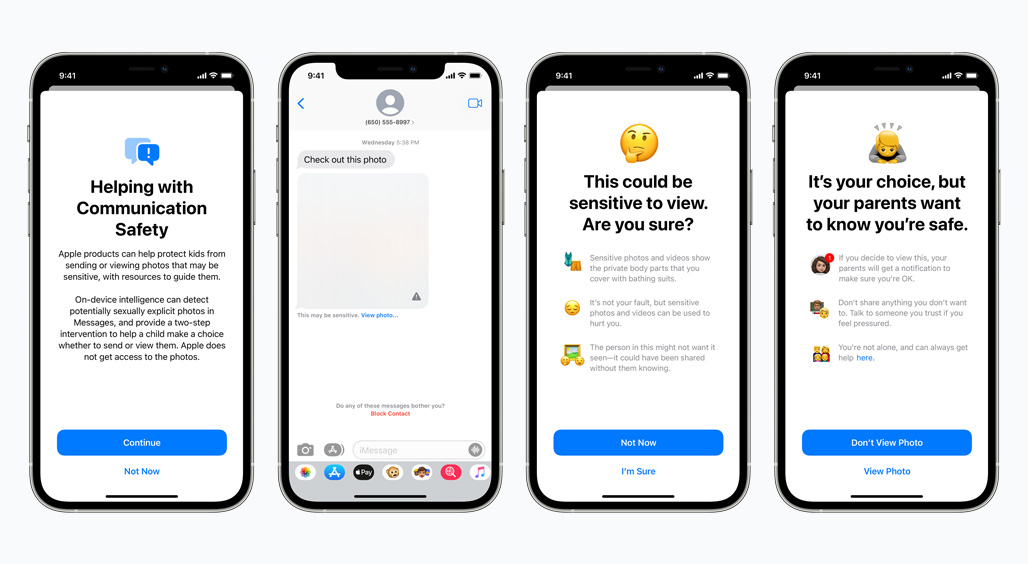

Seguridad en la comunicación en Mensajes

La app Mensajes añadirá nuevas herramientas para advertir a los niños y a sus padres cuando reciban o envíen fotos sexualmente explícitas.

Cuando se reciba este tipo de contenido, la foto se difuminará y se advertirá al niño. Se le presentarán recursos útiles y se le asegurará que está bien si no quiere ver esa foto. Como precaución adicional, también se le puede decir al niño que, para asegurarse de que está a salvo, sus padres recibirán un mensaje si la ven.

Existen protecciones similares si un niño intenta enviar fotos sexualmente explícitas. El niño será advertido antes de enviar la foto, y los padres pueden recibir un mensaje si el niño decide enviarla.

Mensajes utiliza el aprendizaje automático del dispositivo para analizar las imágenes adjuntas y determinar si una foto es sexualmente explícita. La función está diseñada para que Apple no tenga acceso a los mensajes.

Esta función llegará en una actualización a finales de este año a las cuentas configuradas como familias en iCloud para iOS 15, iPadOS 15 y macOS Monterey.

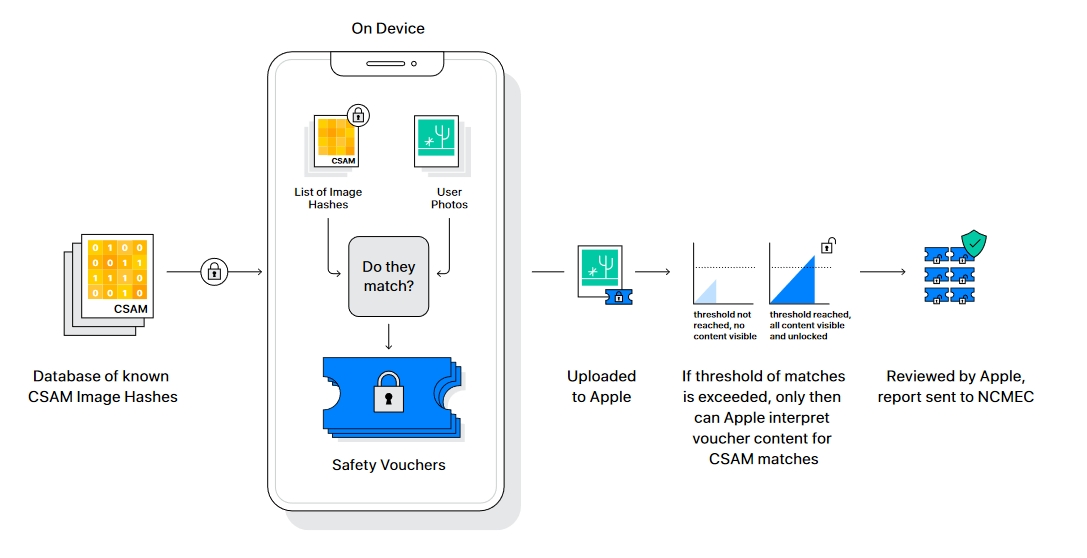

Detección de material de abuso sexual infantil en Fotos

Una nueva tecnología en iOS y iPadOS permitirá a Apple detectar imágenes conocidas de abuso sexual infantil almacenadas en Fotos de iCloud.

Esto permitirá a Apple informar de estos casos al Centro Nacional para Niños Desaparecidos y Explotados (NCMEC), un centro integral de notificación de CSAM que trabaja en colaboración con las fuerzas de seguridad en Estados Unidos.

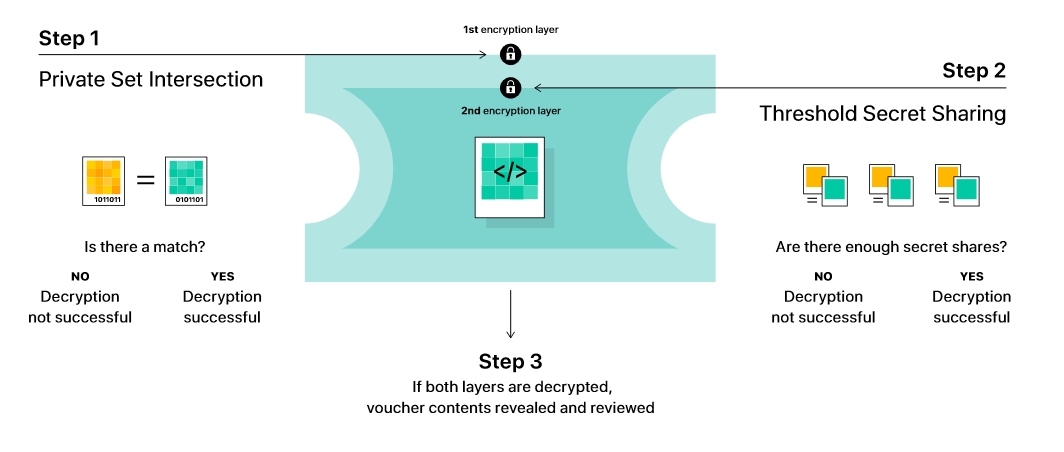

El método de Apple está diseñado teniendo en cuenta la privacidad del usuario. En lugar de escanear las imágenes en la nube, el sistema realiza un cotejo en el dispositivo utilizando una base de datos de hashtags de imágenes conocidas proporcionada por el NCMEC y otras organizaciones de seguridad infantil.

Apple transforma esta base de datos en un conjunto ilegible de hashes que se almacena de forma segura en los dispositivos de los usuarios.

Antes de que una imagen se almacene en Fotos de iCloud, se realiza un proceso de comparación en el dispositivo para esa imagen con los hashes CSAM conocidos. Este proceso de cotejo determina si hay una coincidencia sin revelar el resultado.

El dispositivo crea un vale de seguridad criptográfico que codifica el resultado de la coincidencia junto con datos cifrados adicionales sobre la imagen. Este comprobante se sube a Fotos de iCloud junto con la imagen.

Utilizando otra tecnología llamada umbral de compartición de secretos, el sistema garantiza que el contenido de los vales de seguridad no puede ser interpretado por Apple a menos que la cuenta de Fotos iCloud cruce un umbral de contenido CSAM conocido.

El umbral se establece para proporcionar un nivel de precisión extremadamente alto y garantiza menos de una posibilidad entre un trillón al año de marcar incorrectamente una cuenta determinada.

Sólo cuando se supera el umbral, la tecnología criptográfica permite a Apple interpretar el contenido de los comprobantes de seguridad asociados a las imágenes CSAM coincidentes. A continuación, Apple revisa manualmente cada informe para confirmar que hay una coincidencia, desactiva la cuenta del usuario y envía un informe al NCMEC.

Si un usuario considera que su cuenta ha sido marcada por error, puede presentar un recurso para que se le restablezca la cuenta.

Esta tecnología permite a Apple proporcionar información valiosa y procesable al NCMEC y a las fuerzas del orden en relación con la proliferación de material de explotación infantil conocido.

Y lo hace a la vez que proporciona importantes ventajas en materia de privacidad con respecto a las técnicas existentes, ya que Apple solo se entera de las fotos de los usuarios si tienen una colección de CSAM conocidos en su cuenta de Fotos de iCloud. Incluso en estos casos, Apple sólo aprende sobre las imágenes que coinciden con el CSAM conocido.

Ampliación de la orientación en Siri y en la búsqueda

Apple también está ampliando la orientación en Siri y la Búsqueda proporcionando recursos adicionales para ayudar a los niños y a los padres a mantenerse seguros en línea y obtener ayuda en situaciones inseguras.

Por ejemplo, los usuarios que pregunten a Siri cómo pueden denunciar un caso de abuso sexual infantil o de explotación de menores serán remitidos a recursos para saber dónde y cómo presentar una denuncia.

Siri y Búsqueda también se están actualizando para intervenir cuando los usuarios realizan búsquedas relacionadas con el CSAM. Estas intervenciones explicarán a los usuarios que el interés por este tema es perjudicial y problemático, y proporcionarán recursos de los socios para obtener ayuda con este asunto.

Estas actualizaciones de Siri y Búsqueda llegarán a finales de este año en una actualización de iOS 15, iPadOS 15, watchOS 8 y macOS Monterey.