Google unió cinco Pixel 3 en modo «Frankenstein» para entrenar al algoritmo del modo Retrato

El año pasado, el Pixel 2 dejó a todos impresionados por las capacidades de su cámara que, entre otras cosas, era capaz de tomar retratos con una sola lente.

Google llegó incluso a publicar el algoritmo que procesa la información recogida por los píxeles duales de enfoque para conseguir la información de profundidad requerida para la captura de retratos.

📱💻 ¡Chollazos! ¡Hemos seleccionado las mejores ofertas tecnológicas para que tú no pierdas tiempo! [ Saber más ]

Ahora la compañía ha publicado un artículo en el que explica las mejoras introducidas en la tecnología de detección de profundidad del Pixel 3. Una gran parte de las mejoras se debe a la evolución de las redes neuronales, pero Google también tiene ha utilizando una especie de «Frankenstein» formado por cinco Pixel 3 unidos para entrenar la red neuronal de detección de profundidad.

El sistema utilizado por el Pixel 2 para recopilar información de profundidad era bueno pero no infalible. Ciertas escenas con abundantes líneas horizontales podían confundir al sistema a la hora de detectar diferencias entre la información captada por los píxeles adyacentes.

Para mitigar este problema, el Pixel 3 complementa la información de profundidad captada por los píxeles duales con datos adicionales, utilizando lo que Google llama claves semánticas y de desenfoque — se trata del tipo de cosas que los humanos podemos captar fácilmente mirando una foto cuando vemos los tamaños relativos de los objetos y la borrosidad.

Lo que es fácil de para los humanos puede ser difícil para los ordenadores, así que la solución que Google ha elegido para interpretar estas señales ha sido una red neuronal. Y las redes neuronales no «funcionan» por sí solas, sino que necesitan ser entrenadas para funcionar.

Por ello, Google construyó un Frankenstein formado por cinco Pixel 3 capaz de capturar fotos desde cinco ángulos a la vez. Dado que las imágenes provenían del mismo hardware sobre el que el modelo debe ser entrenado, el resultado sería más preciso.

Además, las imágenes tomadas desde ángulos adicionales suministrarían aún más datos de profundidad para entrenar al sistema a eliminar la confusión con las líneas horizontales.

Tras multitud de fotos captadas por este monstruoso conjunto, Google fue capaz de entrenar a la red neuronal para que captara esas señales más sutiles, combinándolas con los datos de profundidad de los píxeles duales y la detección de personas. Así, la compañía logró una precisión aún mayor en la generación de mapas de profundidad en el Pixel 3.

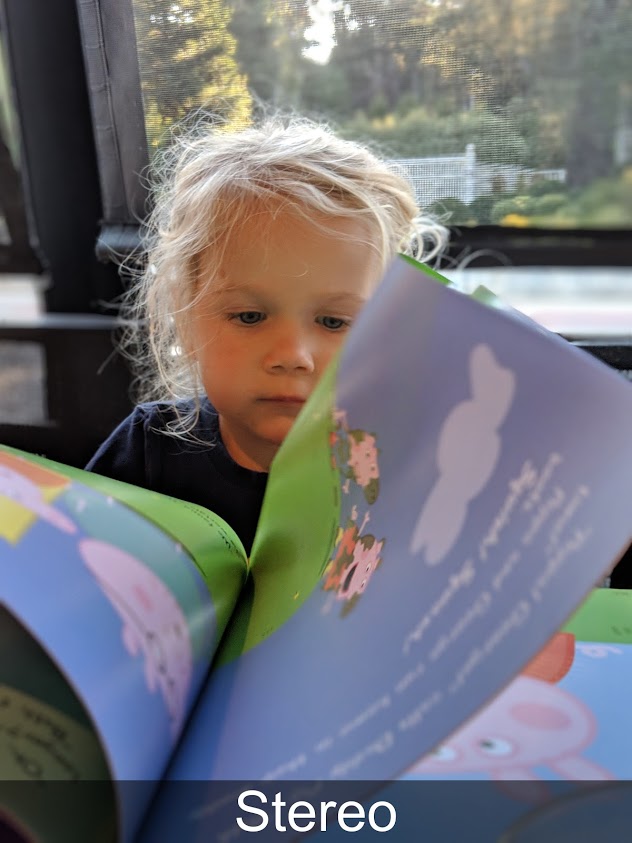

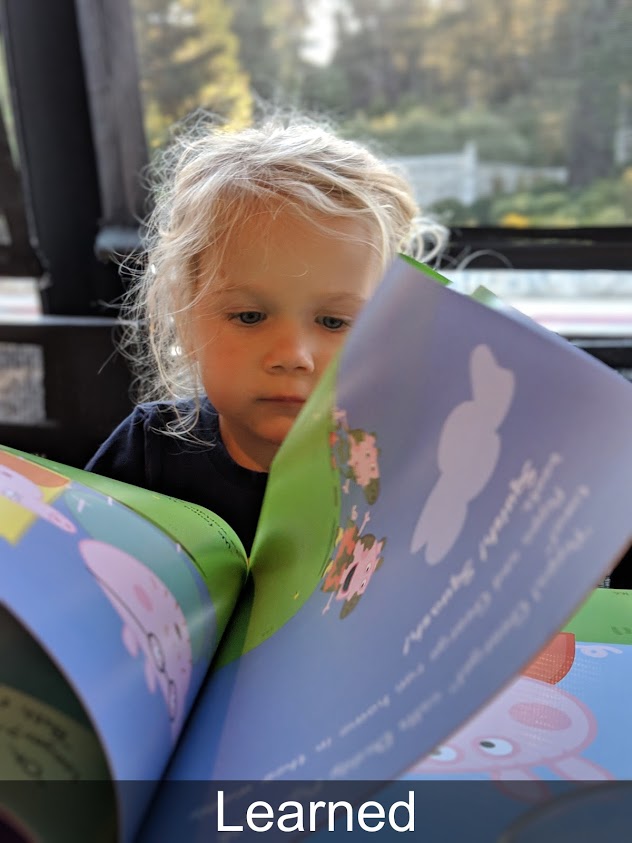

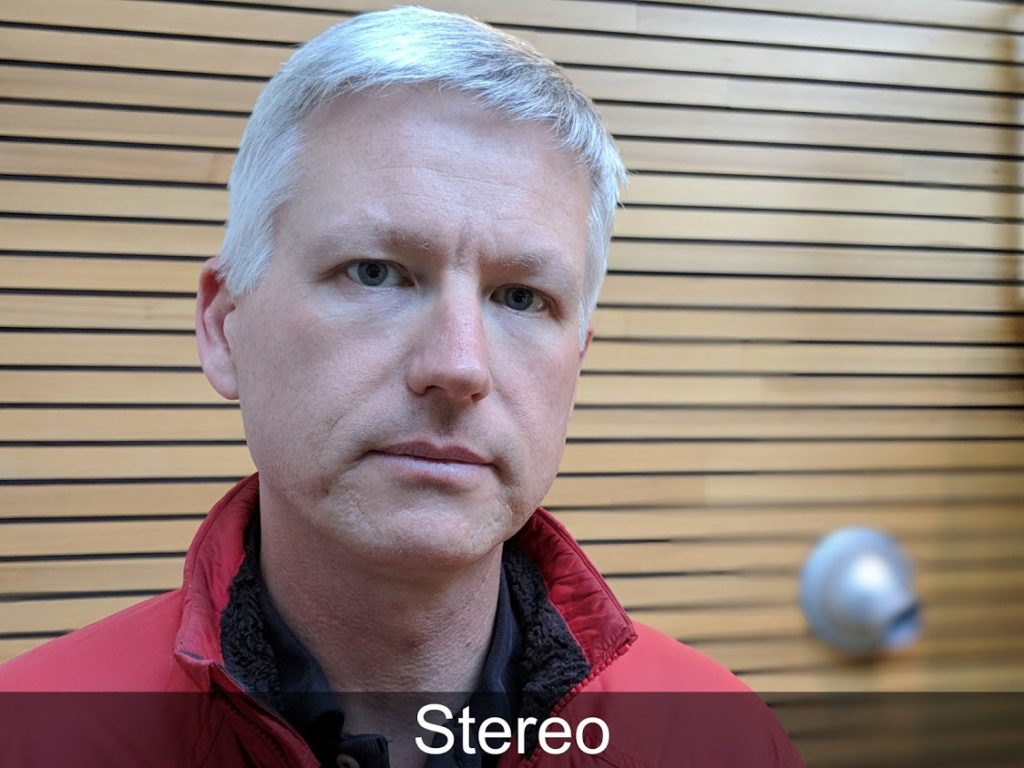

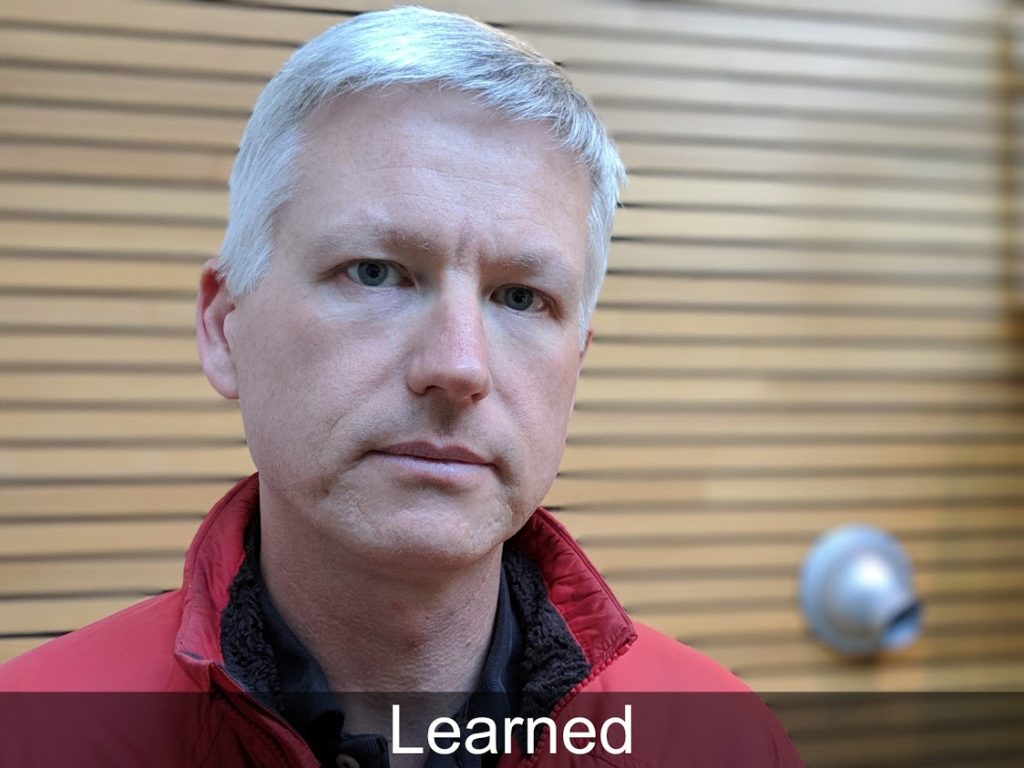

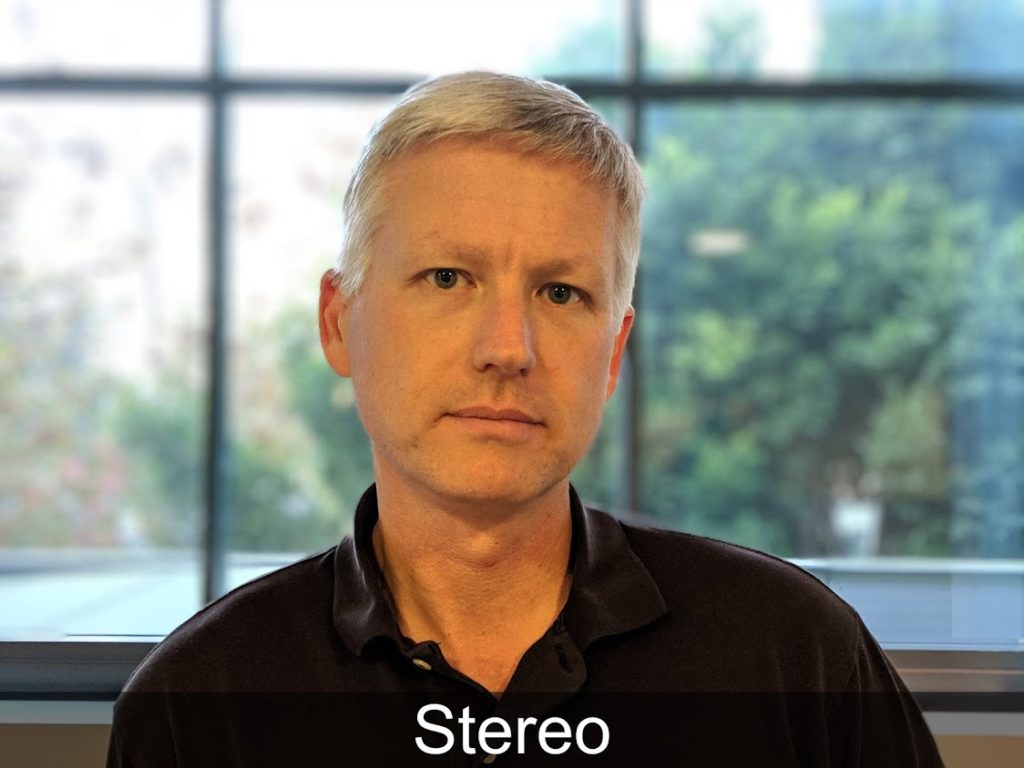

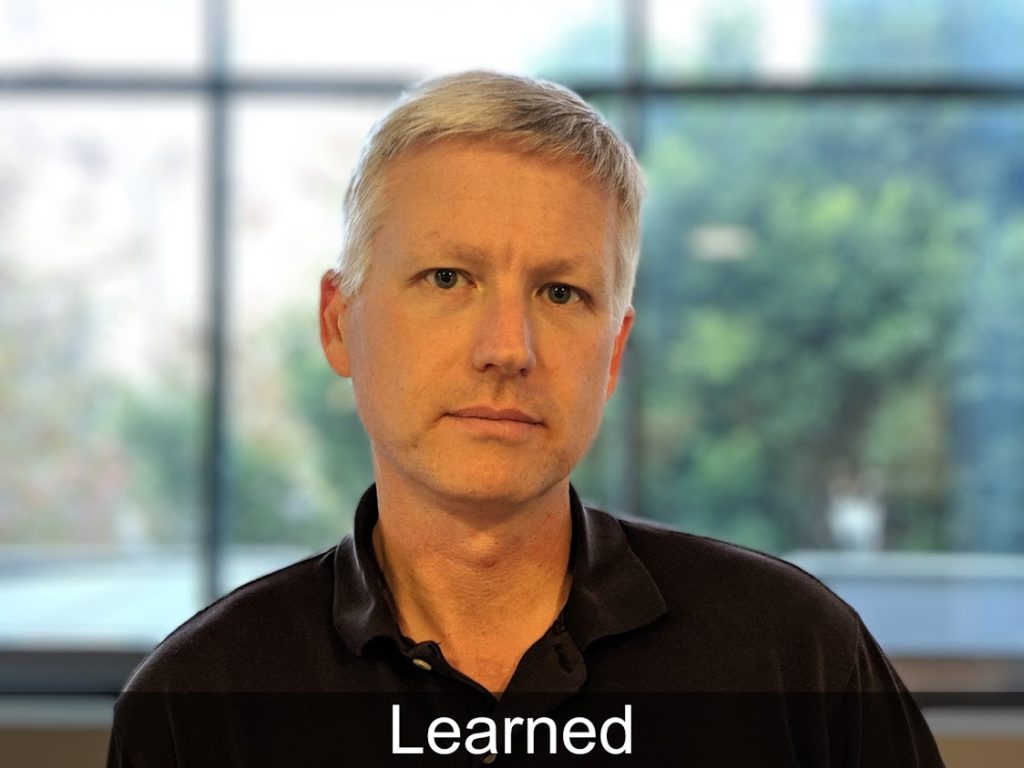

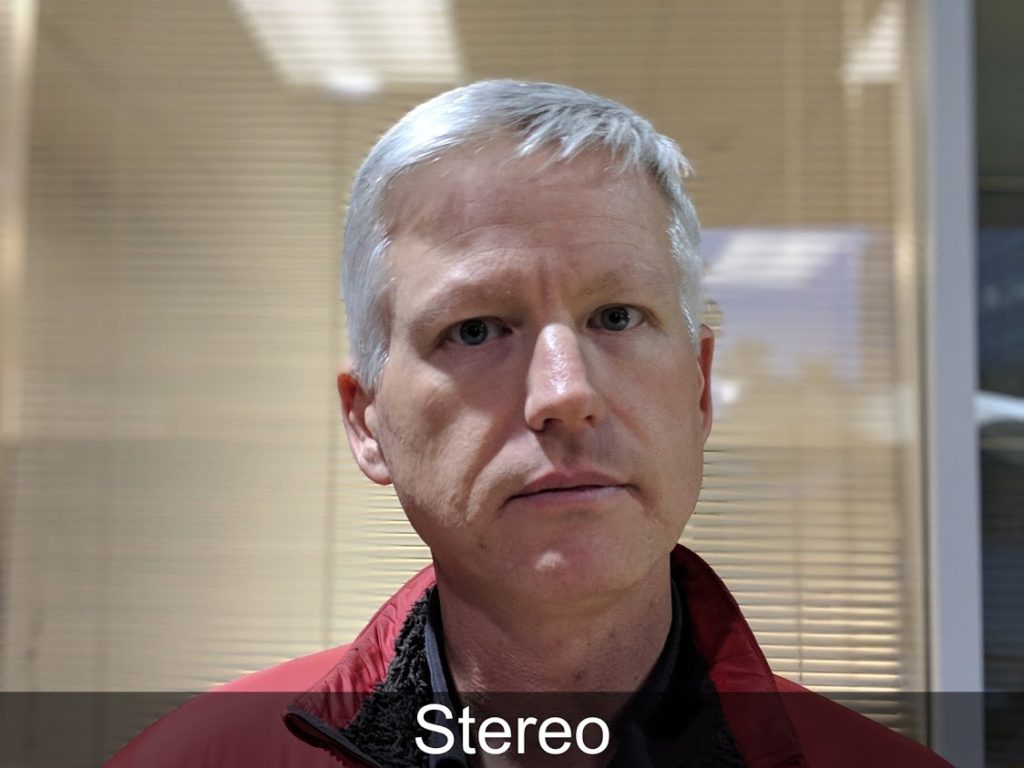

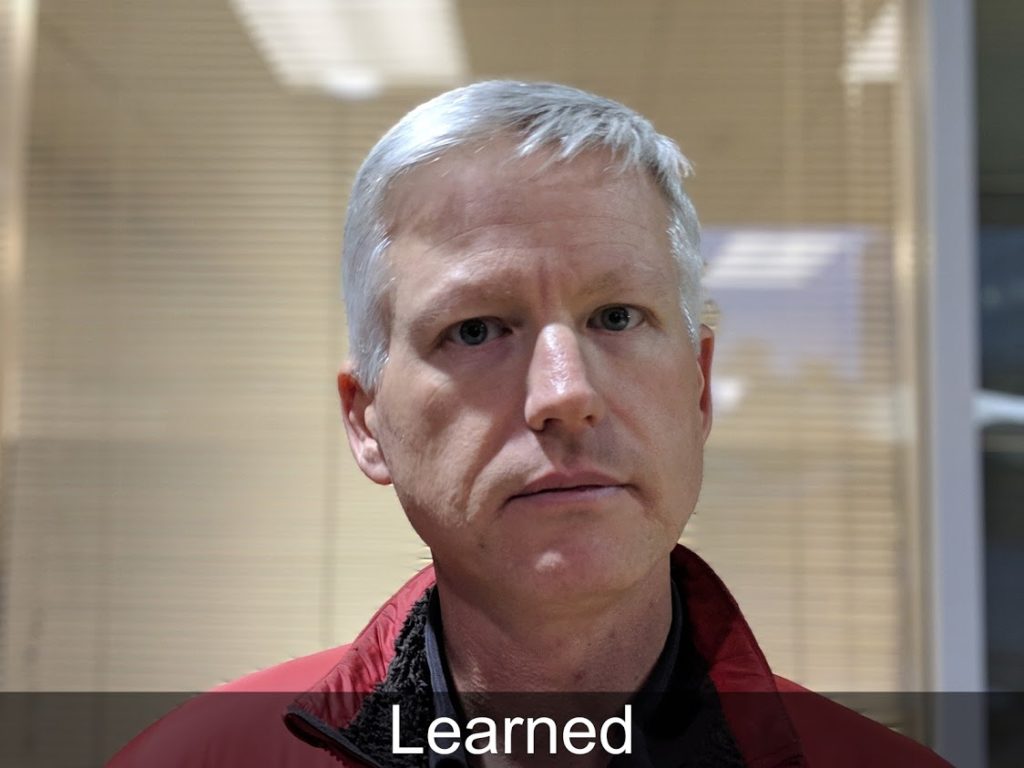

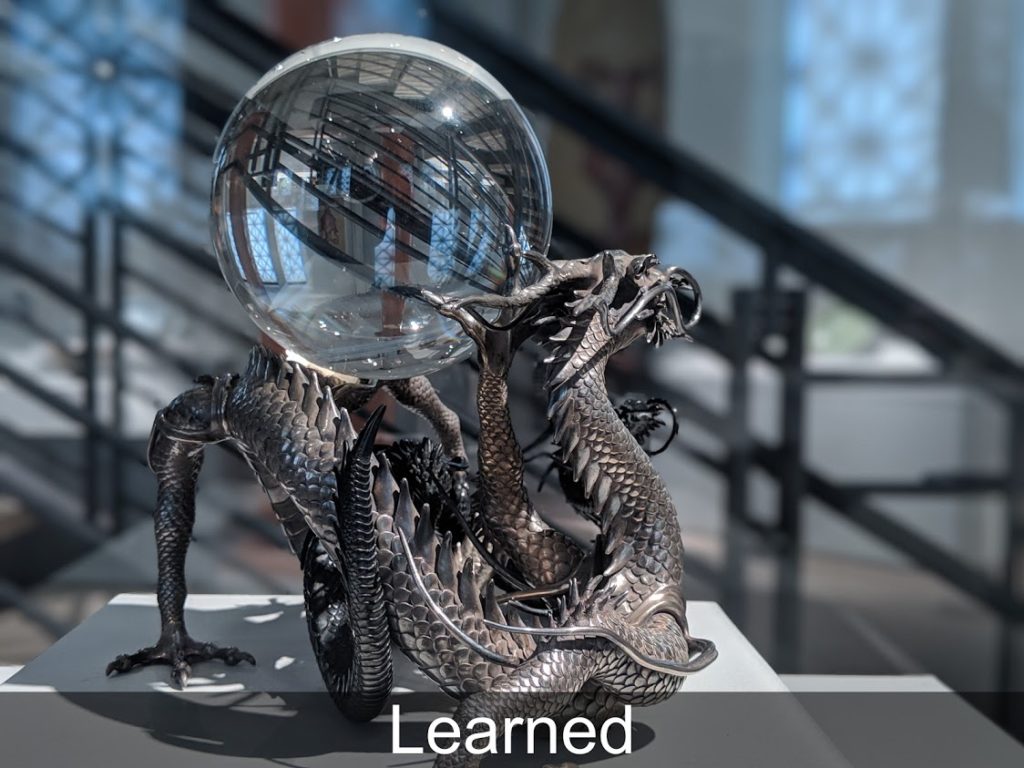

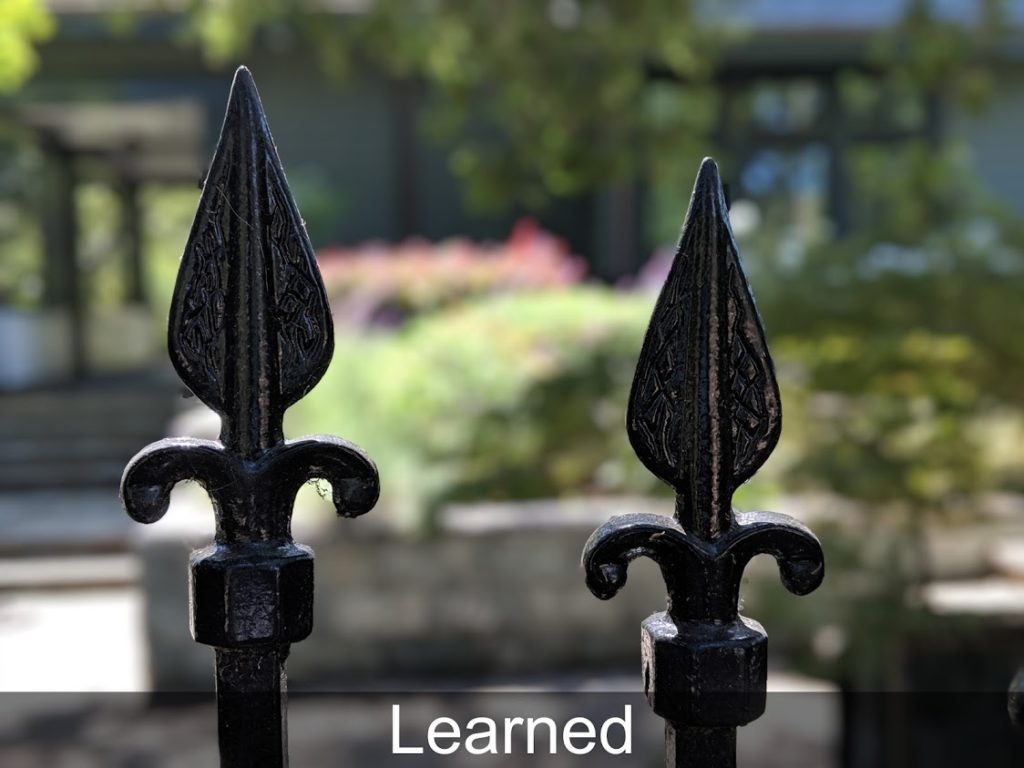

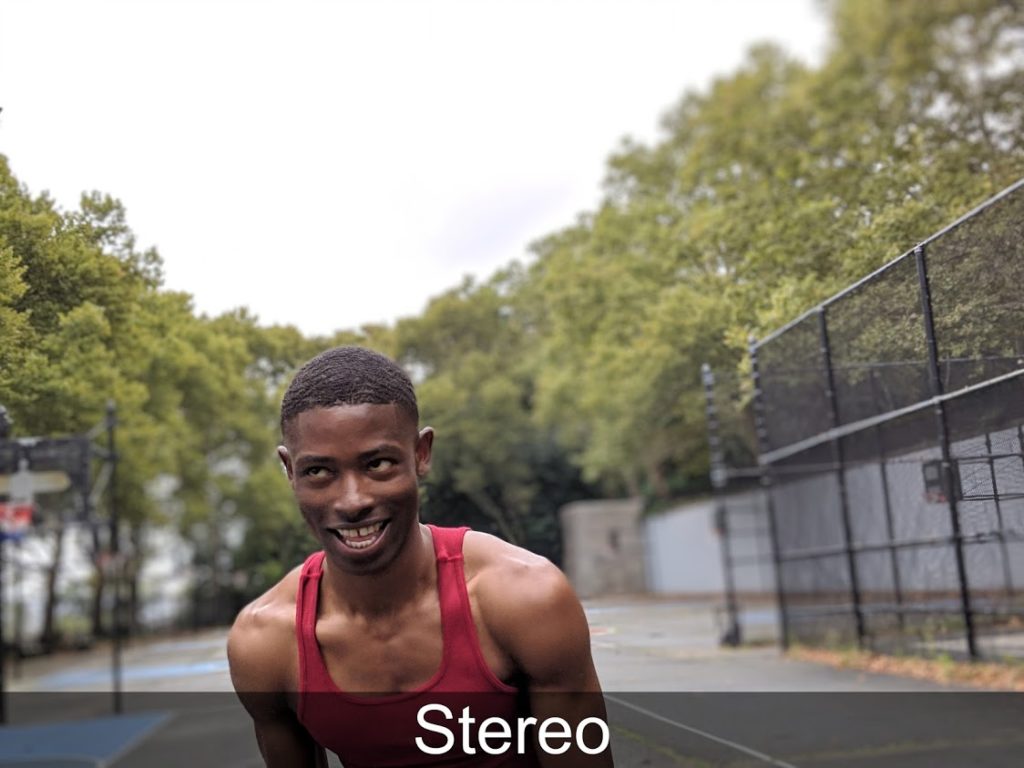

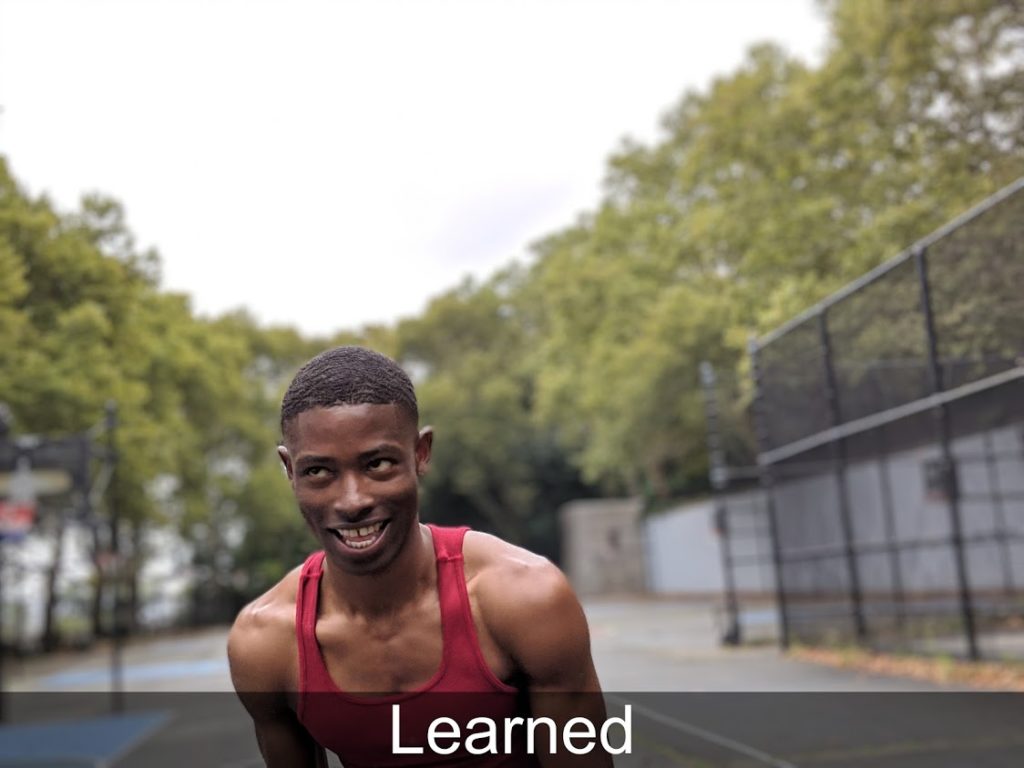

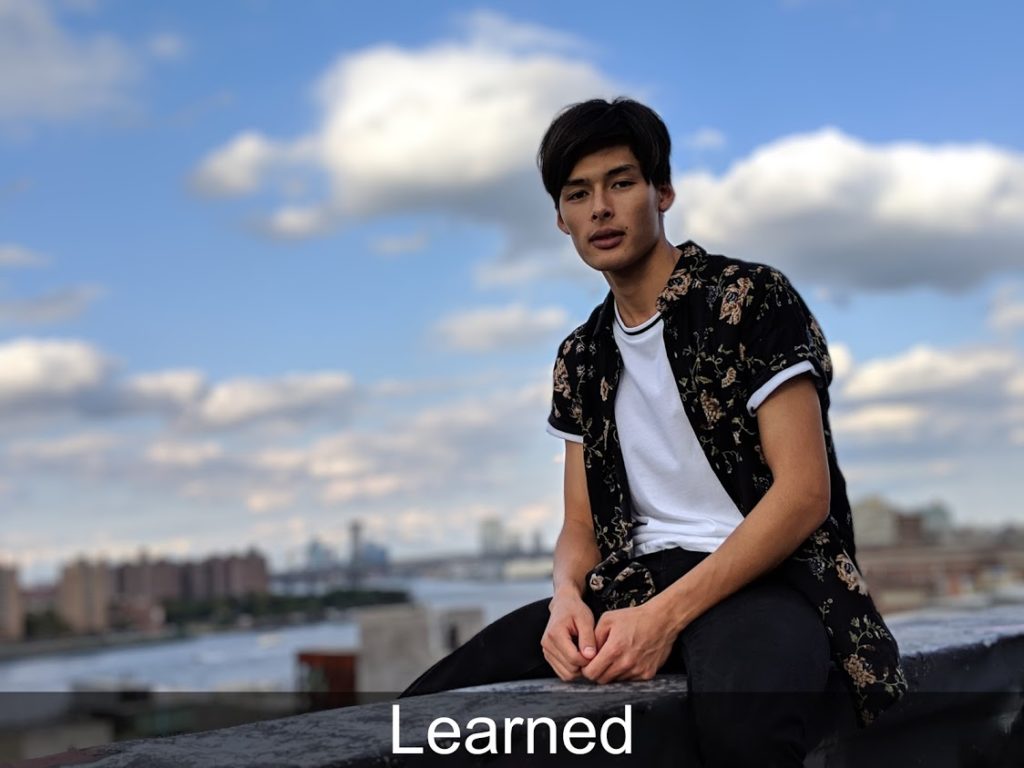

A continuación podemos ver los ejemplos que ha compartido Google, en los que la imagen marcada como ‘Stereo’ corresponde al sistema utilizado en el Pixel 2 y la imagen marcada como «Learned» hace referencia al sistema empleado en el Pixel 3.

Algunos de los cambios son bastante sutiles, pero todos son una mejora importante con respecto a los datos originales.